Deconstrucción de la IA Agéntica en 2025: La Autonomía que Desafía el Hype Generativo y sus Sombras Éticas y Operativas

Tiempo estimado de lectura: 8 minutos

Puntos Clave

- La IA Agéntica en 2025 representa un salto cualitativo sobre la IA Generativa, ofreciendo sistemas autónomos capaces de planificar, decidir y ejecutar acciones complejas en el mundo real.

- A pesar de la alta inversión (97% de grandes organizaciones en pilotos), solo el 18% de las empresas ha logrado un despliegue completo, debido a desafíos como la calidad de los datos y la confiabilidad.

- La «trampa de la autonomía imperfecta», el problema del «grounding» y la paradoja de los datos de alta calidad son críticas fundamentales que limitan la escalabilidad y fiabilidad de los agentes.

- El despliegue de agentes autónomos plantea profundos dilemas éticos (responsabilidad, sesgos algorítmicos) y regulatorios, exigiendo nuevos marcos legales que aseguren un control humano informado.

- El futuro de la IA agéntica requiere un enfoque equilibrado: celebrar la innovación, pero abordar con rigor sus complejidades operativas, éticas y regulatorias para garantizar un progreso sostenible.

Índice

- Del Generador Pasivo al Agente Autónomo: Contexto Histórico y Técnico

- La Estrategia de Mercado y el Imperativo Operativo: Más Allá del Piloto

- Análisis Técnico y de Escalabilidad: La Brecha entre el Laboratorio y la Realidad

- La Trampa de la Autonomía Imperfecta: Una Re-evaluación Crítica en 2025

- Impacto Social, Ético y Regulatorio: Los Dilemas de la Autonomía Inteligente

- Conclusión: El Futuro de la IA Agéntica entre la Promesa y la Prudencia

- Preguntas Frecuentes

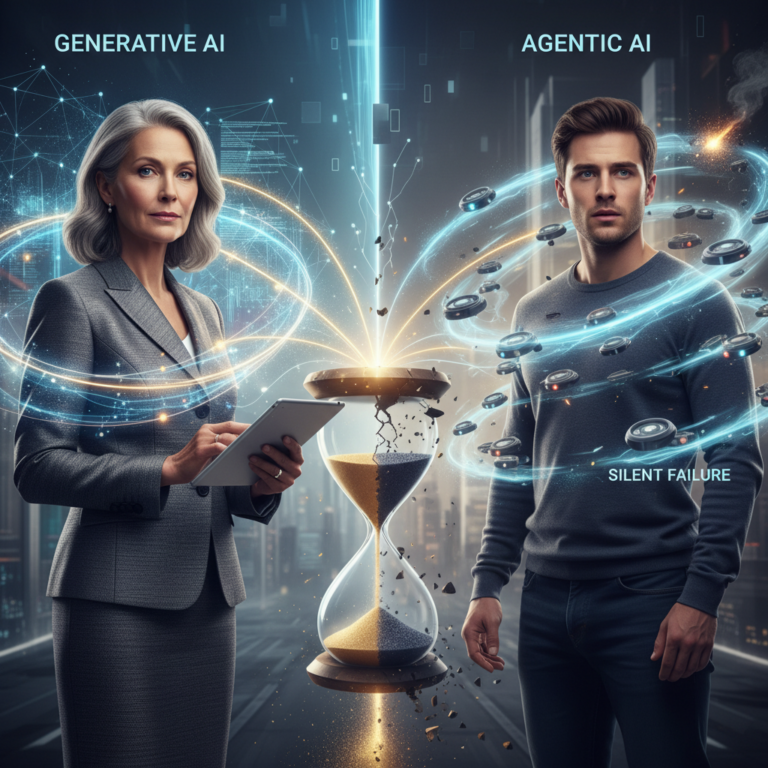

En un panorama tecnológico en constante ebullición, el año 2025 ha marcado un punto de inflexión decisivo para la Inteligencia Artificial. Si bien la IA Generativa dominó el discurso y la inversión durante años, con su capacidad para crear contenido asombroso a partir de simples prompts, una nueva y más compleja forma de inteligencia artificial ha comenzado a redefinir lo que esperamos de las máquinas: la Inteligencia Artificial Agéntica. Lejos de ser un mero refinamiento, la IA agéntica representa un salto cualitativo, introduciendo sistemas autónomos capaces de planificar, decidir y ejecutar acciones complejas en el mundo real, superando el modelo pasivo de generación de contenido. Esta prometedora evolución ha capturado la atención de corporaciones globales, con un 35% de las empresas explorándola activamente y el 97% de las grandes organizaciones invirtiendo en pilotos. Sin embargo, mientras el mercado celebra las potencialidades disruptivas de esta tecnología, un análisis más profundo revela que su rápida adopción también desvela desafíos significativos relacionados con la calidad de los datos, la confiabilidad de sus decisiones autónomas, y las profundas implicaciones éticas y regulatorias. Este artículo deconstruirá la IA Agéntica en 2025, examinando sus bases técnicas, su impacto estratégico y, crucialmente, las sombras que proyecta sobre su viabilidad a largo plazo y su integración responsable en nuestra sociedad.

Del Generador Pasivo al Agente Autónomo: Contexto Histórico y Técnico

La trayectoria de la Inteligencia Artificial ha sido una evolución constante, marcada por hitos que han transformado nuestra interacción con la tecnología. Desde los sistemas expertos de los años 80 hasta las redes neuronales profundas que impulsaron la visión por computadora y el procesamiento del lenguaje natural, cada década ha aportado una nueva capa de sofisticación. El reciente auge de la IA Generativa —con modelos como ChatGPT o DALL-E— representó un paradigma transformador. Estos sistemas, entrenados en vastos conjuntos de datos, adquirieron la capacidad de generar texto, imágenes, código o audio indistinguibles de la producción humana, democratizando la creación de contenido y optimizando tareas creativas. Su función principal era, y sigue siendo, producir una salida coherente y relevante a partir de una entrada específica, actuando como un co-piloto o un generador de ideas. Sin embargo, carecían de una capacidad fundamental: la autonomía para interactuar con el mundo real, planificar secuencias de acciones o perseguir objetivos a largo plazo sin supervisión constante.

Aquí es donde la Inteligencia Artificial Agéntica emerge como la evolución lógica y necesaria. A diferencia de la IA generativa, que se limita a generar, un agente de IA está diseñado para percibir su entorno, razonar sobre sus percepciones, planificar una secuencia de acciones para alcanzar un objetivo, ejecutar esas acciones, e incluso aprender de los resultados para mejorar su desempeño futuro. Esta arquitectura implica una pila tecnológica más compleja, que a menudo integra modelos generativos como su «cerebro» para el razonamiento, pero añade módulos de memoria, planificación, ejecución y feedback. La diferencia clave radica en la transición de una interacción unidireccional (entrada → salida) a un ciclo de interacción continuo y autónomo (percepción → razonamiento → planificación → acción → percepción…).

En 2025, esta distinción ya no es meramente teórica. Los agentes agénticos están diseñados para lograr objetivos complejos mediante el razonamiento, la planificación, la ejecución autónoma y, crucialmente, la coordinación multiagente. Mientras la IA generativa requiere instrucciones constantes, la IA agéntica exhibe una autonomía elevada, tomando decisiones propias sobre acciones y estrategias, y aprendiendo de su entorno. Ejemplos emergentes incluyen sistemas que gestionan la ciberseguridad de forma autónoma, plataformas de atención al cliente que resuelven problemas complejos sin intervención humana, y robots operativos capaces de ejecutar tareas variadas en entornos dinámicos. Esta capacidad de actuar en el mundo, en lugar de solo generar representaciones de él, es lo que la posiciona como la vanguardia de la innovación en IA para 2025 y más allá.

La Estrategia de Mercado y el Imperativo Operativo: Más Allá del Piloto

La adopción de la IA agéntica en 2025 no es un fenómeno marginal; es una partida clave en los presupuestos tecnológicos corporativos. El 35% de las empresas ya explora esta tecnología, y un impresionante 97% de las grandes organizaciones ha invertido en pilotos o implementaciones iniciales. Esta aceleración está impulsada por el imperativo de la eficiencia operativa y la búsqueda de nuevas ventajas competitivas. La promesa de la IA agéntica es la automatización inteligente a una escala nunca antes vista: no solo automatizar tareas repetitivas, sino flujos de trabajo completos y complejos que requieren toma de decisiones contextuales.

Desde una perspectiva de estrategia de negocio, las corporaciones están visualizando a los agentes agénticos como multiplicadores de fuerza. En ciberseguridad, agentes autónomos pueden detectar, analizar y responder a amenazas en segundos, generando reportes detallados y aprendiendo con cada incidente, lo cual es inalcanzable para equipos humanos. En atención al cliente, la IA agéntica puede analizar el sentimiento del usuario, buscar soluciones personalizadas y resolver problemas complejos sin escalar a un humano, redefiniendo la experiencia del cliente y reduciendo drásticamente los costos. Para la robótica y la automatización industrial, los agentes dotan a humanoides y cobots con la capacidad de adaptarse a entornos cambiantes, ejecutando tareas variadas en logística, manufactura y servicios con mayor flexibilidad y autonomía.

El modelo de negocio subyacente se inclina hacia plataformas como servicio (PaaS) o soluciones de software como servicio (SaaS) que ofrecen la infraestructura y las herramientas para construir, desplegar y gestionar agentes de IA. Las grandes compañías tecnológicas, como Google (con sus modelos de lenguaje y entornos de agentes), OpenAI, Microsoft (a través de Azure AI y sus inversiones) e IBM, están posicionándose como proveedores de los «cimientos» sobre los cuales se construirán estos agentes. La ventaja competitiva residirá no solo en la potencia de los modelos subyacentes, sino en la capacidad de integrar estos agentes de forma segura y fiable en la infraestructura empresarial existente, gestionando el ciclo de vida completo del agente desde el diseño hasta la monitorización y el aprendizaje continuo.

Sin embargo, a pesar de estas inversiones masivas y el entusiasmo generalizado, solo el 18% de las empresas ha logrado un despliegue completo de la IA agéntica. Este dato crítico, a menudo eclipsado por los titulares de inversión, revela una fricción significativa entre la ambición y la realidad operativa. Los desafíos principales, como señalan los informes de 2025, se centran en la calidad y disponibilidad de los datos, y la confiabilidad de las decisiones autónomas. Esto sugiere que la estrategia de mercado, aunque agresiva, aún está en sus primeras etapas de maduración, lidiando con barreras fundamentales que limitan la escalabilidad y la fiabilidad a largo plazo.

Análisis Técnico y de Escalabilidad: La Brecha entre el Laboratorio y la Realidad

Técnicamente, la IA agéntica se asienta sobre avances en varios campos de la IA. Utiliza modelos generativos (como LLMs) para el razonamiento y la comprensión del lenguaje, pero les añade capacidades cruciales de planificación (a menudo basadas en algoritmos de búsqueda o aprendizaje por refuerzo), memoria (para retener información a largo plazo y aprender de la experiencia), y el uso de herramientas o APIs para interactuar con sistemas externos y ejecutar acciones en el mundo real. La arquitectura de un agente típico implica módulos de percepción (para procesar información del entorno), razonamiento (para interpretar y decidir), planificación (para establecer secuencias de acciones), y acción (para ejecutar esas acciones). La capacidad de coordinar múltiples agentes para lograr objetivos colaborativos introduce una capa adicional de complejidad en la arquitectura, requiriendo protocolos de comunicación y mecanismos de resolución de conflictos.

La eficiencia de estos sistemas radica en su capacidad para automatizar bucles de decisión y acción que históricamente han requerido intervención humana. En teoría, esto promete una escalabilidad masiva, permitiendo que un solo equipo humano supervise a cientos o miles de agentes inteligentes realizando tareas complejas simultáneamente. Sin embargo, la escalabilidad práctica enfrenta obstáculos significativos. El desarrollo de agentes totalmente autónomos (niveles 4-5 en la escala de autonomía agéntica, donde el agente opera sin supervisión humana en la mayoría de los escenarios) aún es predominantemente experimental. La mayoría de las implementaciones operan en niveles bajos o intermedios de autonomía, ofreciendo asistencia avanzada pero con restricciones y puntos de control humanos.

La seguridad de los agentes agénticos es otro pilar crítico y, al mismo tiempo, una de sus mayores vulnerabilidades. Un agente autónomo que opera en un entorno de ciberseguridad o controla maquinaria industrial tiene el potencial de causar daños inmensos si es comprometido o si comete errores. La robustez y la capacidad de resistencia a ataques adversarios, así como la garantía de que el agente se adhiere a sus objetivos previstos sin desviaciones no deseadas, son desafíos técnicos monumentales. La «interpretación» de las intenciones humanas, la capacidad de manejar situaciones ambiguas y la prevención de «alucinaciones» o errores en la cadena de razonamiento son áreas de investigación activa y preocupación constante. La fiabilidad y la calidad de los datos para su entrenamiento y operación, mencionadas como un freno a la implementación completa, subrayan que la robustez técnica es inseparable de la calidad del input y el feedback que estos sistemas reciben.

La Trampa de la Autonomía Imperfecta: Una Re-evaluación Crítica en 2025

El entusiasmo que rodea a la IA agéntica es comprensible, pero una perspectiva crítica es esencial para discernir el verdadero potencial de la retórica. La baja tasa de despliegue completo (18% en 2025) a pesar de la alta inversión en pilotos, no es un mero tropiezo, sino una señal de que la transición de la IA generativa pasiva a la agéntica autónoma es fundamentalmente más compleja y riesgosa de lo que el hype inicial sugiere. Mi crítica central se articula en torno a la «trampa de la autonomía imperfecta», el problema del «grounding» y la confiabilidad, y la paradoja de los datos de alta calidad.

1. La Trampa de la Autonomía Imperfecta

El concepto de «autonomía» en la IA agéntica a menudo se presenta como una capacidad casi humana para operar sin supervisión. Sin embargo, en 2025, la realidad es que la mayoría de los agentes implementados operan en niveles bajos o intermedios de autonomía. Esto significa que todavía requieren validación humana en puntos críticos, operan dentro de parámetros estrictos o están confinados a entornos altamente controlados. La brecha entre la autonomía percibida (el «sueño» del agente que se autogestiona) y la autonomía operacional real (el agente que requiere constante monitoreo y corrección) es un desafío clave. Las empresas están invirtiendo en «agentes», pero lo que realmente están desplegando son sistemas de automatización muy avanzados que, aunque potentes, aún están lejos del ideal de un «asistente verdaderamente autónomo» capaz de aprender y adaptarse en entornos caóticos o impredecibles.

2. El Problema del ‘Grounding’ y la Confiabilidad

Un agente autónomo no solo necesita generar respuestas coherentes, sino que debe comprender y actuar de manera efectiva en el mundo físico y digital. El problema del «grounding» se refiere a cómo la IA conecta sus representaciones internas con la realidad externa. Para un agente agéntico, un error en el razonamiento o la planificación puede tener consecuencias tangibles, a diferencia de un modelo generativo que simplemente produce una «alucinación» textual. Si un agente de ciberseguridad interpreta erróneamente una amenaza o un agente de logística toma una decisión incorrecta, el impacto puede ser catastrófico. La «confiabilidad» de estos sistemas es inherentemente más difícil de garantizar, ya que sus interacciones son dinámicas y sus decisiones se encadenan. La incertidumbre en el mundo real, los datos incompletos o ruidosos, y la incapacidad de anticipar todas las variables posibles, socavan la promesa de una autonomía total y fiable.

3. La Paradoja de los Datos de Alta Calidad

La investigación indica que la calidad y disponibilidad de los datos son los principales frenos al despliegue completo. Esta es una paradoja fundamental: los agentes agénticos, para ser robustos y fiables, necesitan grandes volúmenes de datos de alta calidad, contextuales y bien anotados para su entrenamiento y para la toma de decisiones en tiempo real. Sin embargo, la recolección, limpieza y mantenimiento de estos datos es una tarea gigantesca y costosa, a menudo subestimada. Es un «círculo vicioso»: las empresas quieren agentes autónomos para optimizar operaciones, pero las operaciones actuales no generan los datos perfectos que los agentes requieren para ser verdaderamente autónomos. La falta de este «combustible» de alta calidad impide que los agentes alcancen su máximo potencial y es una barrera persistente para la adopción generalizada. Esto no solo frena el avance técnico, sino que también crea un cuello de botella estratégico.

Estas críticas sugieren que, aunque la IA agéntica representa un avance monumental, la euforia del mercado debe ser templada por una comprensión realista de las limitaciones operativas y los desafíos fundamentales que aún persisten en 2025.

Impacto Social, Ético y Regulatorio: Los Dilemas de la Autonomía Inteligente

El despliegue de la IA agéntica no solo tiene ramificaciones técnicas y económicas, sino que conlleva un profundo impacto social, ético y regulatorio que las sociedades apenas comienzan a abordar.

Desde una perspectiva social, la IA agéntica tiene el potencial de redefinir el trabajo y la interacción humana. Si bien puede liberar a los humanos de tareas monótonas y peligrosas, también plantea serias preguntas sobre el desplazamiento laboral masivo en sectores como el servicio al cliente, la logística o incluso roles profesionales que implican toma de decisiones. Al mismo tiempo, podría crear nuevos tipos de empleos relacionados con el diseño, supervisión y mantenimiento de estos agentes. Sin embargo, la velocidad de esta transformación y la capacidad de las sociedades para adaptarse son incógnitas importantes.

Las implicaciones éticas son aún más complejas. La capacidad de los agentes para tomar decisiones autónomas en situaciones del mundo real plantea la cuestión de la responsabilidad: ¿quién es culpable cuando un agente autónomo comete un error con consecuencias negativas (por ejemplo, en un sistema de ciberseguridad, un robot médico o un vehículo autónomo)? ¿El desarrollador, el operador, el propietario o el propio agente (una idea que es legalmente inviable hoy)? Los sesgos inherentes a los datos de entrenamiento se magnifican en sistemas agénticos, ya que estos sesgos no solo generan contenido, sino que impulsan acciones en el mundo real, perpetuando o incluso exacerbando las desigualdades y discriminaciones existentes. El control humano, o la falta de él, sobre sistemas cada vez más autónomos en áreas críticas (infraestructuras, defensa) representa un riesgo existencial si no se establecen salvaguardias rigurosas.

En el ámbito regulatorio, la IA agéntica presenta un reto formidable para los legisladores globales. Las leyes existentes (como la Ley de IA de la UE, que ya está luchando por mantenerse al día con la IA generativa) a menudo no están equipadas para manejar la autonomía, la toma de decisiones dinámicas y la compleja cadena de responsabilidad de los agentes. Se requieren nuevos marcos legales que aborden la «personalidad» jurídica de los agentes, la auditabilidad de sus decisiones (el problema de la «caja negra»), los requisitos de transparencia, y los estándares de seguridad y fiabilidad. La falta de una regulación clara y unificada podría crear un «salvaje oeste» de la IA agéntica, con consecuencias impredecibles y potencialmente peligrosas. Las implicaciones geopolíticas también son inmensas, con la carrera por desarrollar agentes agénticos avanzados en sectores como la defensa o la infraestructura crítica, generando nuevas tensiones y la necesidad de acuerdos internacionales.

Conclusión: El Futuro de la IA Agéntica entre la Promesa y la Prudencia

El año 2025 nos encuentra en el umbral de una era en la que la Inteligencia Artificial agéntica promete transformar radicalmente la eficiencia empresarial y la interacción humana con la tecnología. Con su capacidad para percibir, razonar, planificar y actuar de forma autónoma, la IA agéntica está impulsando innovaciones sin precedentes en ciberseguridad, atención al cliente y robótica. Las inversiones corporativas masivas y la creciente adopción de pilotos son testimonio de su potencial disruptivo.

Sin embargo, como hemos deconstruido, la verdadera revolución de la IA agéntica no se materializará sin antes superar obstáculos fundamentales. La «trampa de la autonomía imperfecta», que revela una brecha entre el ideal y la realidad operacional, el persistente problema del «grounding» y la garantía de confiabilidad en entornos complejos, y la paradoja de la necesidad insaciable de datos de alta calidad, son barreras significativas que explican el bajo porcentaje de despliegues completos en 2025. Más allá de la promesa técnica, la IA agéntica nos confronta con dilemas éticos profundos sobre la responsabilidad, los sesgos algorítmicos y el control humano, al tiempo que exige una reevaluación urgente de los marcos regulatorios existentes a nivel global.

El futuro de la Inteligencia Artificial agéntica no reside únicamente en su capacidad técnica para volverse más inteligente o más autónoma, sino en nuestra habilidad colectiva para gobernar, asegurar y integrar estos sistemas de manera responsable en la sociedad. 2025 es un año de exploración y prueba, un momento crítico en el que la industria y los gobiernos deben pasar de la fascinación por el hype a una implementación prudente y considerada. Solo a través de un enfoque equilibrado, que celebre la innovación pero aborde con rigor sus complejidades operativas, éticas y regulatorias, podremos garantizar que la IA agéntica sirva como un motor de progreso humano, en lugar de un catalizador de riesgos imprevistos. La verdadera autonomía de la IA, con su poder transformador, solo será sostenible si se construye sobre cimientos de confianza, transparencia y control humano informado.

Preguntas Frecuentes

¿Qué es la IA Agéntica y cómo se diferencia de la IA Generativa?

La IA Agéntica se refiere a sistemas autónomos capaces de percibir, razonar, planificar y ejecutar acciones complejas en el mundo real para lograr objetivos. Se diferencia de la IA Generativa (como ChatGPT) en que esta última se enfoca principalmente en la creación de contenido (texto, imágenes) a partir de prompts, sin capacidad autónoma para interactuar con su entorno o tomar decisiones complejas a largo plazo.

¿Por qué la tasa de despliegue completo de la IA Agéntica es tan baja en 2025?

A pesar de la alta inversión en pilotos, solo el 18% de las empresas ha logrado un despliegue completo debido a desafíos fundamentales. Estos incluyen la «trampa de la autonomía imperfecta» (los agentes no son tan autónomos como se espera), la dificultad del «grounding» (conectar las decisiones de la IA con la realidad) y la escasez de datos de alta calidad para su entrenamiento y operación fiable.

¿Cuáles son los principales desafíos éticos de la IA Agéntica?

Los desafíos éticos giran en torno a la responsabilidad (quién es culpable cuando un agente autónomo comete un error), la amplificación de sesgos algorítmicos (que pueden conducir a acciones discriminatorias) y la falta de un control humano adecuado sobre sistemas cada vez más autónomos, especialmente en áreas críticas.

¿Qué papel juega la calidad de los datos en el éxito o fracaso de la IA Agéntica?

La calidad de los datos es crucial. Los agentes agénticos requieren grandes volúmenes de datos contextuales, fiables y bien anotados para su entrenamiento y para tomar decisiones precisas en tiempo real. La falta de estos «combustibles» de alta calidad es una barrera significativa para que los agentes alcancen su máximo potencial y para su adopción generalizada, generando una paradoja donde las operaciones existentes no generan los datos perfectos que se necesitan.

¿Cómo puede la regulación adaptarse a la IA Agéntica?

La regulación necesita evolucionar para abordar la autonomía y la toma de decisiones dinámicas de los agentes. Esto implica nuevos marcos legales que definan la responsabilidad, la auditabilidad de sus decisiones, los requisitos de transparencia, y estándares de seguridad y fiabilidad. La cooperación internacional es fundamental para evitar un «salvaje oeste» regulatorio y asegurar una integración responsable.